Techniki eksploracji procesów są od kilku lat stosowane do zwiększania wydajności procesów. Warto jednak pamiętać, że process mining jest kontynuacją trendów technologicznych i opiera się na dekadach doświadczenia w zarządzaniu i standaryzacji czynności procesowych. W poniższym tekście umieściliśmy process mining we właściwym kontekście historycznym, który pozwala na lepsze zrozumienie znaczenia tej technologii dla nowoczesnego zarządzania procesowego

Tayloryzm

Wpływowy nowożytny nurt związany z wydajnością procesową to Tayloryzm. Nazwa pochodzi od Fredericka Taylora (1856-1915), który począwszy od 1877 pracował w Midvale Steel Company. W toku pracy Taylor nie tylko zdołał wprowadzić wiele usprawnień w procesie produkcji, ale też zbudować sposób myślenia o zwiększaniu jej wydajności. Z początkiem XX wieku takie podejście zaczęto nazywać naukowym zarządzaniem (ang. scientific management). Taylor odrzucał powszechną wtedy (choć niejednokrotnie również dzisiaj) ideę, że wiele prac wykonywanych przez pracowników wymaga dogłębnej wiedzy branżowej, a tym samym nie mogą one zostać rozbite na elementy i analizowane. Taylor jednak udowodnił, że metoda naukowa jak najbardziej może posłużyć do analizy i podnoszenia wydajności pracowników. Niektóre z wyników jego pracy były kontrowersyjne lub podważały obiegową opinię. Przykładowo, mierząc czas wykonania zadań przez pracowników, odkrył, że przy stałej pensji lepsi pracownicy zaczynają pracować wolniej aby się dostosować do słabszych pracowników. Dlatego postulował powiązanie wynagrodzenia z wynikami. Postulował również organizowanie przerw w pracy gdyż badania ilościowe pokazywały jasno, że odpoczynek podnosił wydajność pracowników.

Frederick Taylor

Z perspektywy czasu szczególnie istotne jest analityczne podejście do wydajności procesowej. Metoda Taylora to dekomponowanie pracy na poszczególne czynności, pomiar czasu oraz poprawności wykonania tych czynności, a finalnie analiza zebranych w ten sposób danych. To podejście jest bardzo zbieżne z podejściem process mining z tą różnicą, że dzisiaj dzięki technologii nie musimy zbierać ręcznie danych. Wystarczy je gromadzić w systemach informatycznych. Co więcej, algorytm sam odkryje za nas proces na podstawie zebranych danych. Gdyby Frederick Taylor mógł zobaczyć współczesne rozwiązania process mining zapewne stwierdziłby, że całe życie marzył o takiej technologii.

Masowa produkcja

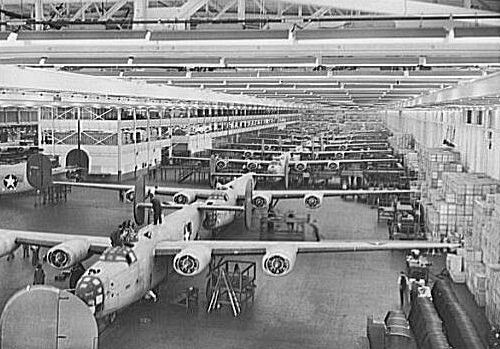

Z początkiem XX wieku znaczenia nabrała organizacja pracy określana jako masowa produkcja. Sukcesy firm Ford Motor Company oraz General Motors pokazały, że możliwe jest stworzenie ogromnych fabryk produkujący w bardzo wydajny sposób skomplikowane maszyn np. samochodów. Sama produkcja była zorganizowana wokół linii montażowych, pozwalających na płynne przemieszczenie elementów z jednego stanowiska na drugie. Aby utrzymać płynność pracy kluczowe było skrupulatne planowanie oraz wysoka standaryzacja komponentów i samego procesu. Tutaj doświadczenie wyniesione z Tayloryzmu było szczególnie istotne. To właśnie rozbijanie prac na elementy oraz ich analiza stanowiły punkt wyjścia dla planowania i standaryzacji. Szczególny test dla masowej produkcji stanowiła II Wojna Światowa. William Knudsen, szef General Motors, na prośbę prezydenta Franklina Roosevelta podjął się zadania przestawienia amerykańskiej gospodarki na produkcję sprzętu wojskowego. Knudsen skoordynował produkcję broni w duchu masowej produkcji. I uczynił to tak skutecznie, że USA w krótkim czasie produkowały sprzęt nie tylko na własne potrzeby, ale też dla Wielkiej Brytanii, ZSRR i innych armii alianckich.

Fabryka Ford Motors Company w Willow Run produkująca bombowce B-24 Liberator

Dzisiaj często myślimy o masowej produkcji z punktu widzenia ekonomii skali – duży wolumen przekłada się na niski koszt jednostkowy. Jednak u podstaw sukcesu masowej produkcji leżał ogromny nacisk na doskonałość realizacji procesu. Czynności wykonywane w fabryce były ciągle analizowane, cały czas szukano lepszych rozwiązań. Prowadziło to do wysokiej niezawodności procesu produkcji i dopiero taki proces mógł być skutecznie skalowany. Bez ciągłej analizy procesu nie byłoby to możliwe.

Lean management

To koncepcja zarządzania produkcją, która zyskała popularność z końcem minionego wieku. Oryginalnie wywodzi się z metod produkcji rozwijanych w zakładach Toyota począwszy od lat 30-tych XX wieku. Kluczowe znaczenie miały dwa nazwiska – Shigeo Shingo oraz Taiichi Ohno – którzy w okresie po II Wojnie Światowej zbudowali najważniejsze elementy systemu produkcyjnego Toyoty. Podejście to było twórczą aplikacją Tayloryzmu oraz masowej produkcji do specyficznych uwarunkowań lokalnych. Japonię cechowały: ubogie zasoby surowców naturalnych, konieczność importowania ich na ogromne dystanse drogą morską, niedobór kapitału, niska dostępność gruntów przy wysokim zaludnieniu i relatywnie wysokim bezrobociu. Wszystko to powodowało, że Toyota kładła przede wszystkim nacisk na minimalizację strat materiałów oraz wydajną logistykę i łańcuchy dostaw. Metody rozwijane w tym duchu określa się dzisiaj jako lean management i zakładają one m.in. dostawy just-in-time, wysoką elastyczność produkcji i dostaw względem zmian rynkowych oraz redukcję strat, z tym, że redukcja strat nie jest ograniczona tylko do produkcji, ale obejmuje cały łańcuch wartości aż po dostawę produktu do klienta. Dzięki temu możliwe jest utrzymanie niskich stanów magazynowych i niejednokrotnie produkowanie bezpośrednio pod zamówienia klientów.

W lean management widzimy ewolucję myślenia nad wydajnością procesów. Usprawnianie procesów nie dotyczy już tylko czynności wykonywanych w pojedynczych zakładach pracy. Lean management to zbieranie informacji na całej długości łańcucha wartości – od zamówienia aż do dostawy do klienta. Wykorzystanie tego rodzaju danych może dać kapitalne wyniki, jednak wiąże się z coraz większą ilością oraz złożonością elementów, które podlegają analizie i które chcemy optymalizować.

Six sigma

Dalsze prace nad zwiększeniem poprawności realizacji procesów doprowadziły do powstania technik six sigma. Były one rozwijane przez Billa Smitha podczas pracy w Motoroli w latach 80-tych. Sama nazwa dotyczy terminu sigma „σ”, jakim w statystyce określa się odchylenie standardowe od średniej. Six sigma to przede wszystkim wykorzystanie statystyki i analizy danych do identyfikacji źródeł defektów oraz wariancji w jakości produkcji a następnie usunięcie tych przyczyn. Aby usystematyzować proces zbierania i analizy danych, prace organizowane są w oparciu o wystandaryzowane metodyki DMAIC oraz DMADV.

Techniki w obszarze Six Sigma opierają się na zbieraniu i analizie danych w jeszcze w większym stopniu niż w przypadku lean management. Z punktu widzenia analizy procesu stanowi to wyzwanie. Zbieranie danych to proces żmudny, niejednokrotnie dostarczający tylko częściowych informacji. Co więcej, z powodu ogromnego wysiłku poświęconego na przygotowanie analiz można stracić po drodze inicjatywę i kreatywność i zastąpić je miarami statystycznymi.

Modelowanie procesów biznesowych

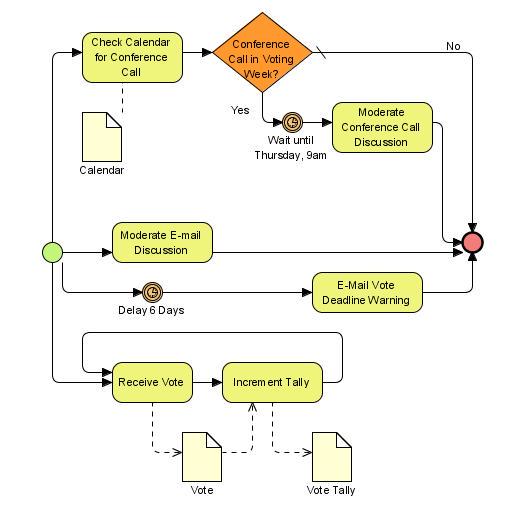

Wraz z rosnącą standaryzacją zarządzania procesami pojawiły się formalne notacje, za pomocą których można zapisywać procesy biznesowe. W 2005 roku wskutek połączenia Business Process Management Initiative oraz Object Management Group powstało jednolite ciało odpowiedzialne za utrzymanie i rozwój takiej formalnej notacji. Jest nią Business Process Model and Notation (BPMN) i jest ona standardowo wykorzystywana do opisywania procesów biznesowych.

Przykład BPMN – proces zbierania głosów

Patrząc przez pryzmat analizy procesu trudnością w ich modelowaniu jest fakt, że trudno jest rzeczywistość zakląć w zamknięty logiczny i spójny wewnętrznie opis. Czynności odbiegające od procesu modelowego nie stanowią wyjątku, lecz regułę. Pracownicy potrafią zignorować przyjęte procedury czy też twórczo je interpretować zależnie od zmieniającej się sytuacji i kontekstu. Trudności nastręcza również fakt, że organizacja to żywy organizm, którego procesy biznesowe cały czas ewoluują. Wszystko to powoduje, że poprawne odwzorowanie i opomiarowanie procesów w logice BPMN jest czasochłonne i kosztowne. Często pełne odwzorowanie procesów jest właściwie niemożliwe.

Gdzie tu miejsce na process mining?

Przedstawione powyżej metody w zarządzaniu produkcją stanowiły i nadal stanowią źródło innowacji i wzrostu wydajności. Na przestrzeni dekad dawały one managerom sposób myślenia, cele i narzędzia. Dzięki temu mogli oni przeszczepiać gotowe metodyki zarządzania do własnych organizacji i skutecznie osiągać cele biznesowe.

Process mining nie ma aż tak daleko zakrojonych, holistycznych ambicji. Jest to przede wszystkim narzędzie, które może być dopasowane do każdej z powyższych metodyk czy też filozofii zarządzania. O sile process mining nie stanowi „całkowita zmiana paradygmatu”. Raczej ten zestaw technik analitycznych umożliwia o wiele wydajniejszą i łatwiejszą analizę procesów biznesowych. Tym samym jest to narzędzie o ogromnej przydatności dla każdego z przedstawionych w artykule nurtów:

- w kontekście Tayloryzmu i masowej produkcji process mining umożliwia łatwe przypisanie czasów i czynności w ramach procesu oraz ich analizę. Daje to wiele możliwości analizy procesów i ich usprawniania.

- w przypadku Lean management dzięki process mining możemy łatwo uchwycić i przypisać KPI do czynności realizowanych na całej długości łańcucha wartości.

- w inicjatywach Six sigma process mining pozwoli oszczędzić dużą ilość czasu związanego z przygotowaniem danych oraz ich analizą. Po prostu za pomocą algorytmów process mining praca z danymi procesowymi jest o wiele łatwiejsza i szybsza.

- A w przypadku modelowanie procesów biznesowych process mining bezpośrednio adresuje jedną z kluczowych trudności BPMN jaką jest mapowanie procesu. Dzięki process mining możemy oddać tę pracę w ręce algorytmu, który sam odkryje i zbuduje proces, a zaoszczędzony czas przeznaczyć na analizę i usprawnianie procesu.

Skąd się wziął process mining?

W tworzeniu narzędzi process mining przewodnią rolę odegrał Wil van der Aalst. Jest to holenderski naukowiec i informatyk związany pierwotnie z uczelnią Technische Universiteit Eindhoven (TU/e) a aktualnie pracujący na RWTH Aachen University. Wil wraz z zespołem rozwijał techniki analizy procesowych począwszy od lat 90-tych. Wiele rozwiązań, bibliotek, pakietów oprogramowania oraz startupów wywodzi się bezpośrednio z prac van der Aalsta oraz jego współpracowników. Ważne dla organizacji prac nad process miningiem było utworzenie w 2009 roku w ramach IEEE grupy zajmującej się process miningiem – Task Force on Process Mining. Grupa ta jest odpowiedzialna m.in. za Process Mining Manifesto oraz za standaryzację narzędzi i formatów danych dla process mining. Duże znaczenie w popularyzacji wśród użytkowników miało uruchomienie przez Wila van der Aalsta na Coursera.org kursu z technik process mining. Jest on dostępny dla każdego i bezpłatny (opłaty są powiązane jedynie z certyfikatem).

Wil van der Aalst

Początkowo, process mining był zagadnieniem rozwijanym przede wszystkim w świecie akademickim. Sytuacja zmieniła się w 2012 roku wraz z pojawieniem się niemieckiego startupu Celonis, który z powodzeniem oferował rozwiązania dla klientów komercyjnych. Dzisiaj dostawców jest wielu – własną platformę oferuje m.in. UiPath, znany na polskim rynku z rozwiązań RPA. Mimo wszystko nadal prym wiodą prace akademików. To oni wyznaczają kierunek rozwoju technologii. Co warto podkreślić – są to naukowcy w przeważającej większości europejscy. Process mining jest technologią, w której to Europa jest liderem.

Konkluzja

Process mining to nie jest nowy paradygmat, lecz nowe narzędzie. To oznacza, że nie musimy zmieniać metodyk, a jedynie uzupełnić je o zestaw technik analitycznych, które radykalnie ułatwią analizę i usprawnianie procesów biznesowych. Pod wieloma względami process mining stanowi Święty Graal inżynierów którzy od XIX wieku poszukiwali metod na lepszą analizę i zrozumienie procesów. Na szczęście dzisiaj technologie IT oraz algorytmy dają nam taką możliwość i warto z niej skorzystać.

Chcesz przeczytać więcej o Process Mining? Zobacz artykuły:

Co to jest process mining?

Dlaczego warto korzystać z process mining?

Czemu wiedza co to process pining okazuje się kluczowa dla biznesu?